Motorblog

Fahrerassistenzsysteme leisten seit einigen Jahren einen wesentlichen Beitrag zur aktiven Sicherheit im Straßenverkehr. Anders als passive Sicherheitssysteme (wie Airbag, Gurtstraffer usw.) versuchen sie Unfälle erst gar nicht entstehen zu lassen. Das ist gar nicht so leicht! Auch wenn es viele nicht wahrhaben wollen, aber es gibt eine erschreckende Zahl: 90.

- 90% aller Autofahrer_innen denken, sie sind gute Fahrer_innen

- 90% aller Autofahrer_innen denken, andere sind schlechte Fahrer_innen

- 90% aller Verkehrsunfälle sind auf menschliches Fehlverhalten zurückzuführen

Offensichtlich hat die Verkehrssicherheit ein großes Problem: Menschen werden schwer verletzt oder sterben, weil andere Menschen Fehler machen. Sei es, dass sie Geschwindigkeiten oder Abstände falsch einschätzen, dass sie mit der Fahrsituation überfordert sind oder das sie schlichtweg emotional reagieren und Verletzungen riskieren.

Neuwagen können mit einer großen Anzahl an Fahrerassistenzsysteme ausgestattet werden, bishin zu teilautomatisierten Fahrfunktionen. Der Weg zum selbstfahrenden Auto ist zwar noch lang, aber der Weg dahin wird beschritten. Nicht zuletzt die Versicherer machen Druck, denn Unfälle kosten Geld. Schön wäre es doch, wenn man auch ältere Fahrzeuge mit moderner Technik ausstatten könnte. Ein nachrüstbares System auf dem Markt ist das Mobileye Kamerasystem.

Nachfolgend ein kurzer, technischer Test des Systems aus Sicht eines Entwicklers.

The Future of Computer Vision and Automated Driving by Prof. Amnon Shashua (MobileEye)

Prof. Amnon Shashua ist Co-founder & CTO von Mobileye und er sprach auf der Deutsche Bank Global Auto Industry Conference.

Inkrementale Verbesserungen in der Computer Vision

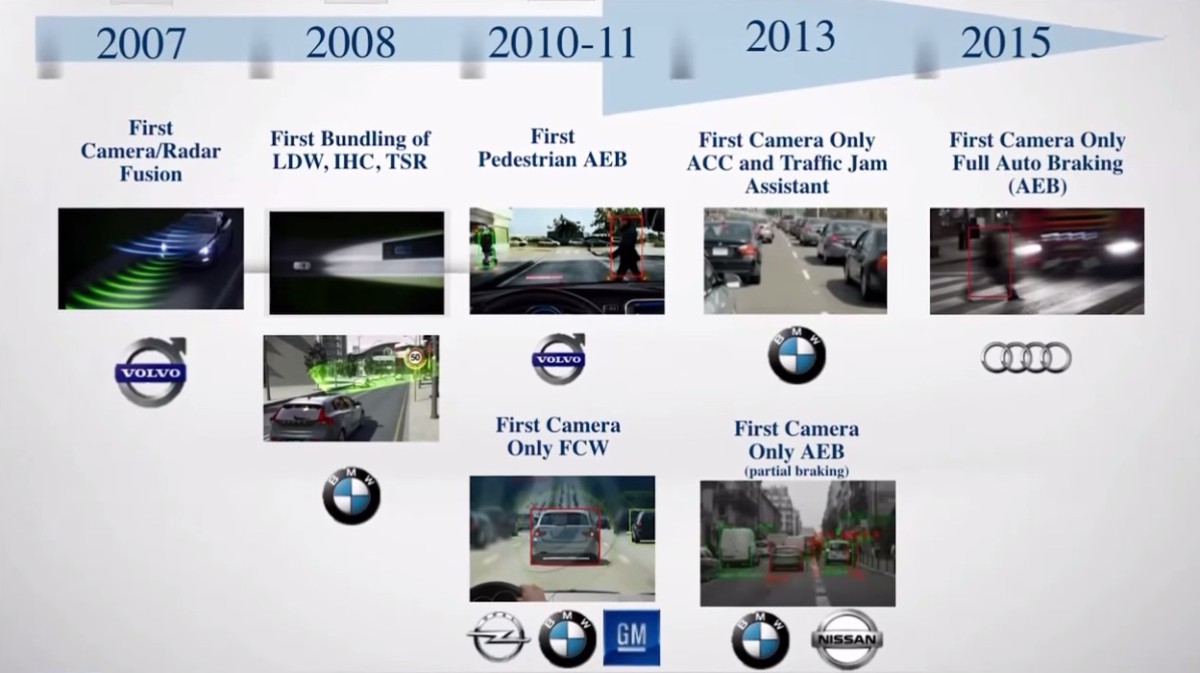

Quelle: Screenshot aus Vortrag Prof. Shashua auf dem Deutsche Bank Global Auto Industry Conference 2015

Er spricht über die historische Entwicklung der Computer Vision für Fahrerassistenzsysteme und auch die zukünftige. So wird beispielsweise dieses Jahr ein automatischer Notbremsassistent bei Audi eingeführt, welcher nur mit Computer Vision als Sensorik funktioniert. Bisher ein klassisches Betätigungsfeld für Radarsensorik oder Lidar.

Er spricht außerdem über False-Positive (d.h. es gibt kein Hindernis, das System hat aber etwas erkannt und ausgelöst) und False-Negative (d.h. es gab ein Hindernis, das Computer Vision System hat es aber nicht erkannt) Auswirkungen für die Detektion von Ereignissen.

Quelle: Screenshot aus Vortrag Prof. Shashua auf dem Deutsche Bank Global Auto Industry Conference 2015

Außerdem wird auf die Fortschritte der Straßenverlaufs- und Hinderniserkennung bei Nacht eingegangen.

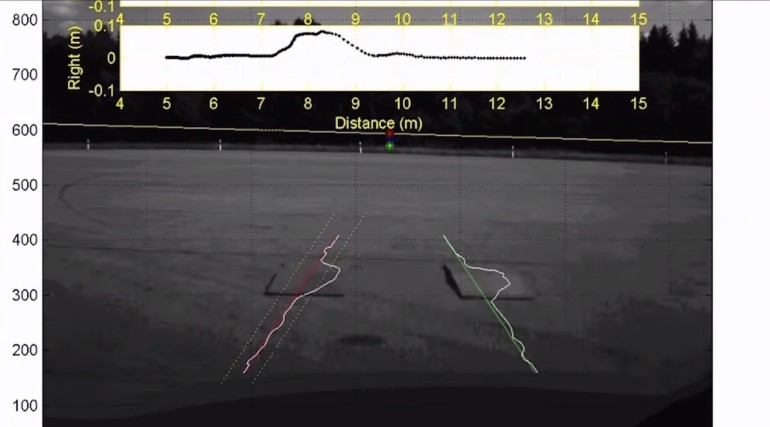

Ebenfalls wird auf die Erkennung von Straßeneigenschaften, d.h. Schlaglöcher oder Schwellen, eingegangen. Diese können relativ genau erkannt und das Fahrwerk bzw. die Geschwindigkeit darauf angepasst werden. Dies wird spätestens bei autonomer Fahrt interessant.

Videosensorik erkennt Straßenunebenheiten. Quelle: Screenshot aus Vortrag Prof. Shashua auf dem Deutsche Bank Global Auto Industry Conference 2015

Möglichkeiten der Umfeldwahrnehmung auf dem Weg zur vollautonomen Fahrt

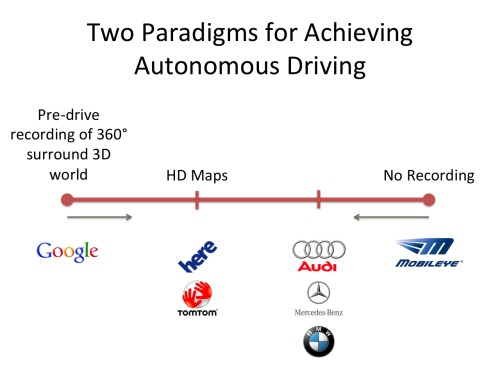

Um das Fahrzeug in der Umgebung sicher bewegen zu können, gibt es verschiedene Ansätze. Google beispielsweise fährt umher und scannt einfach die gesamte Stadt mit 360° Laserscannern in riesigen Punktwolken ab, welche dann zu 3D Modellen zusammen gesetzt werden. Daraus können Straßen, Hindernisse, Ampeln, Bordsteine, Einfahrten etc. extrahiert werden.

Genau auf der anderen Seite der Möglichkeiten steht, gar keine Daten zu sammeln, sondern nur Sensoren immer schauen zu lassen, wie es denn gerade aussieht.

Doch all diese Step-by-Step Verbesserungen reichen nicht, um autonome Fahrt realisieren zu können. Dafür muss ein großer, riesiger Schritt getan werden.

Deep Learning für vollautonome Fahrt

Prof. Shashua spricht über Deep Learning und das MobileEye seit 2 Jahren an der Nutzung von Deep Learning Algorithmen (genauer: Deep Convolutional Networks) für die Umfeldsensorik arbeitet. Dabei war vor allem das Problem der vielen (kleinen) Operationen (mathematischen Faltungen = Convolutions) die Herausforderung, was aber mit dem neuen EyeQ3 Chip wohl gelöst sei.

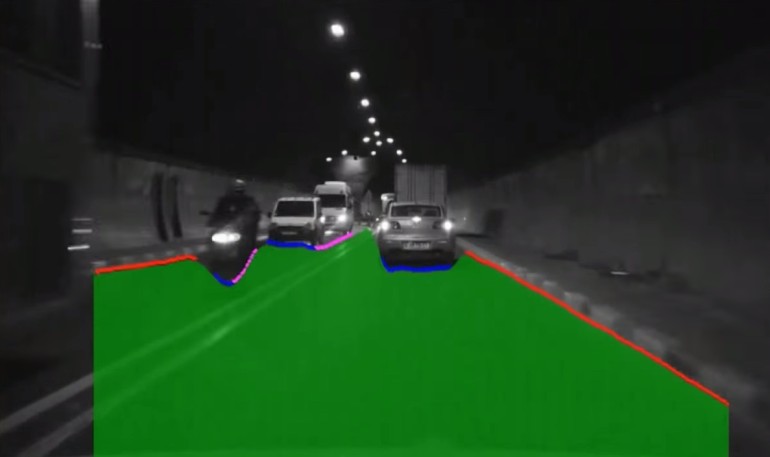

Videosensorik, angelernt mit Deep Learning markiert Pixelgenau, was freier Raum (grün), Fahrbahnbegrenzung (rot), Front/Heck anderer Fahrzeuge (blau) oder Seite anderer Fahrzeuge (pink) ist. Quelle: Screenshot aus Vortrag Prof. Shashua auf dem Deutsche Bank Global Auto Industry Conference 2015

Mit angelernten neuronalen Netzen war es möglich Fahrspuren zu erkennen, selbst wenn keine Fahrbahnmarkierungen zu ‘sehen’ waren. Außerdem erkennt das Netz freie Fahrbahn, Fahrzeuge und Straßenbegrenzungen. Siehe auch ‘Es beginnt selbst zu lernen…‘

Dies ist keine Zukunftsmusik, so Shashua, es wird dieses Jahr einen Fahrzeughersteller geben, der dies in Serie heraus bringen wird. Und er sprach viel über Tesla in diesem Vortrag. :)

Sein Fazit ist, dass die Computer Vision die Sensorik für Fahrerassistenzsysteme werden wird, Radar und Laserscanner nur zur Redundanz bzw. Absicherung eingesetzt werden, falls der Fahrzeughersteller diese Kosten auf sich nimmt. Denn Computer Vision Sensorik ist die mit Abstand günstigste.

Nungut, bei Nebel sieht ein Computer Vision System auch nichts, da muss das Radar die Abstandsinformation liefern.

Lange Rede, kurzer Sinn, hier der Vortrag:

Vortrag ‘Zukunft der Computer Vision und Autonomen Fahrt’ von Prof. Amnon Shashua von MobileEye

Errata: In der ursprünglichen Fassung des Artikels war die Beschreibung für False-Positive und False-Negative vertauscht.