Motorblog

Irgendwann musste es passieren: Ein im automatisierten Fahrbetrieb befindliches Fahrzeug ist in einen Unfall verwickelt und kann die Situation nicht retten. In diesem Fall ist ein Mensch um’s Leben gekommen. Sehr tragisch. Was ist passiert?

Ein Truck biegt an einer Kreuzung links ab und nimmt einem geradeaus fahrenden Fahrzeug die Vorfahrt. Soweit erst einmal ein statistisch gesehen relativ häufiger Vorfall. In diesem Fall war das Fahrzeug ein Tesla Model S im ‘Autopilot’ Modus. Das bedeutet, dass das Fahrzeug selbst die Längs- und Querführung übernommen hat (Lenken & Gas/Bremse). Die Software wird von Tesla unter Realbedingungen ‘beim Kunden’ getestet, sie ist ausdrücklich als Beta Version verfügbar, das bedeutet der Kunde darf sich nicht auf die Fehlerfreiheit verlassen, denn er hat eingewilligt sie als Testfahrer zu nutzen. Mutig von Tesla, deutsche Hersteller haben sich dagegen entschieden, wenngleich sie technisch auch so weit wären.

Es ist ein Unglück, welches durch die Verkettung menschlichen Versagens hervorgerufen wird aber in der Verfehlung der Technik mündet:

- LKW Fahrer nimmt die Vorfahrt

- PKW Fahrer schaut nicht auf die Straße

- Autopilot reagiert nicht

Die mediale Debatte entfaltet sich natürlich in Richtung Tesla und Fehler der “Autopilot” Funktion. Wieso hat der Autopilot das nicht erkannt? Nungut, steigen wir mit ein.

Niemand würde auf die Idee kommen mit verbundenen Augen und den Händen hinterm Rücken zusammen gebunden, durch die Welt zu laufen und erst auf Hindernisse zu reagieren, wenn die Nase diese berührt.

In etwa so geht es aber dem Auto. In ihm übernehmen Beschleunigungssensoren hinter der Stoßstange die Funktion der Nase. Wenn ein Einschlag registriert wird, zünden die Airbags, die Gurte werden gestrafft und eventuell werden Fenster/Schiebedach geschlossen und die Sitze in aufrechte Position gefahren. Dass die zur Verfügung stehende Zeit echt knapp ist, merkt man sofort.

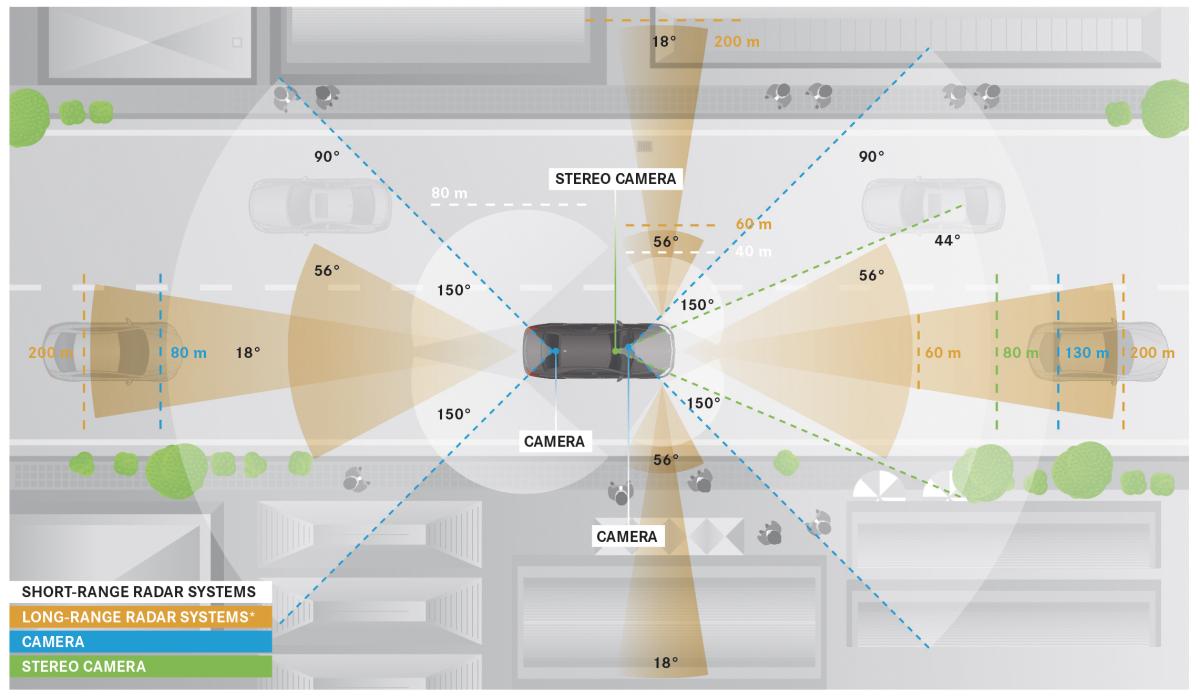

Die Evolution hat uns Menschen Augen gegeben, mit denen wir eine Wand rechtzeitig erkennen und entsprechend reagieren können. Die Physik hat für das Auto Messprinzipien entwickelt, mit welchem es versuchen kann ebenfalls die Umwelt wahrzunehmen. Die Fahrzeugumfeldsensorik hilft dabei, wichtige Informationen über das Fahrzeugumfeld zu sammeln. Die Wichtigsten möchte ich nachfolgend vorstellen.

Deutschlandradio Kultur hat in der Sendung Breitband ein Beitrag zu “Connected Cars: Autonom und vernetzt” gebracht, bei dem ich auch etwas beigesteuert habe. Scheint ganz gut angekommen zu sein:

Podcastrekord! Die Sendung über vernetze Autos, enthemmte Trolle und neue Domains steht online http://t.co/WMf9Y15yuH Es lebe @moritzmetz

— Breitband (@breitband) 26. Juli 2014

Das komplette Interview ist nachfolgend zu hören:

Titelbild: Bunt von Michael Pollak auf Flickr, cc-by

Themen

- Sensoren im Fahrzeug: Kleiner Überblick über Sensoren im Fahrzeug.

- Aufzeichnung der Daten: Ob das Fahrzeug dauerhaft Daten aufzeichnet und speichert ist Geheimnis der Fahrzeughersteller. Ob und wie die Fahrer_innen “bewertet” werden, ist nicht klar. Es gibt jedoch ein paar Anhaltspunkte.

- Begehrlichkeiten für Fahrzeugdaten: Versicherungstarife und Fahrerklassifikation. Ist nicht so einfach, wie viele Marketingbroschüren für Zusatzhardware versprechen. Der Fahrzeughersteller könnte das ganz gut bewerten, aber der verdient sein Geld (noch) mit dem Verkauf von Fahrzeugen.

- Was für Assistenzsysteme sind denn derzeit im Markt? Zum Beispiel Adaptive Geschwindigkeitsregelung mit allen Vorteilen für Komfort und Straßenauslastung.

- Wer hat das letzte Wort, wenn Assistenzsystem und Fahrer_in etwas anderes wollen?

- Die Zukunft: Das selbstfahrende Auto. Wann kommt es?

- Und was ist mit den ethischen Fragen für vollautonome Fahrt?

Worst Case Szenario und Horror für jeden Autofahrer: Ein Mensch kommt hinter einem parkenden Auto vorgelaufen. Die Reaktionszeit des Menschen ist einfach zu lang um darauf zu reagieren. Kann es die aktuelle Technik besser? Der ADAC hat getestet:

Ist für das Wunschfahrzeug ein solches System erhältlich, sollte man es durchaus mit dazu ordern. Denn: Vermeidet man damit einen Unfall, hat es sich mehrfach bezahlt gemacht – Andreas Rigling, ADAC

…von der menschlichen Tragödie mal ganz abgesehen.

Da habe ich aber große Augen bekommen, als Dr. Zetsche heute auf der re:publica davon sprach, dass das Design der Grund wäre, weshalb Fahrzeuge deutscher Produktion mit Radar+Stereokamera ihr Umfeld wahrnehmen und nicht mit einem Laserscanner. Das Google Self-Driving-Car hingegen setzt auf Laserscanner.

Wenn Sie mal so ein Google-Fahrzeug gesehen haben, sieht das in etwa aus wie eine Mondlandefähre. Und dann haben sie oben auf dem Dach diese Teleskop-Geschichte, und die kostet in etwa so viel wie das Auto darunter.

Da mag er Recht haben, denn Google setzt auf Velodyne HDL-64E sensoren, welche 360° Rundumsicht ermöglichen.

[Update 10/2013] Aus einer Dissertation kann man entnehmen, dass auch Daimler mit dem Velodyne arbeitet, was die Aussage von Konzernchef Dr. Zetsche irgendwie noch inhaltsloser erscheinen lässt.

![Auszug aus [Schmid, M. R. (2012). Umgebungserfassung für Fahrerassistenzsysteme mit hierarchischen Belegungskarten. Universität der Bundeswehr München. Retrieved from http://d-nb.info/1030485593/]](https://www.cbcity.de/wp-content/uploads/2013/05/Daimler-Velodyne-770x605.jpg)

Auszug aus [Schmid, M. R. (2012). Umgebungserfassung für Fahrerassistenzsysteme mit hierarchischen Belegungskarten. Universität der Bundeswehr München. Retrieved from http://d-nb.info/1030485593/]

Quelle: Ibeo Laserscanner

– Der Multi-Applikations-Sensor, Braunschweiger Verkehrskolloquium, 2006

Diese Abbildung, welche aus dem Jahr 2006 stammt, zeigt zahlreiche nahtlose Integrationsmöglichkeiten, ich vermute also eher den betriebswirtschaftlichen Teil der Aussage: Denn die Sensoren sind auf Grund fehlender Massenproduktion einfach noch zu teuer.

[Update 10/2013: Auch Daimler schafft das so schön.]

![Auszug aus [Schmid, M. R. (2012). Umgebungserfassung für Fahrerassistenzsysteme mit hierarchischen Belegungskarten. Universität der Bundeswehr München. Retrieved from http://d-nb.info/1030485593/]](https://www.cbcity.de/wp-content/uploads/2013/05/Daimler-E-Klasse-Sick-Lidar-770x542.jpg)

Auszug aus [Schmid, M. R. (2012). Umgebungserfassung für Fahrerassistenzsysteme mit hierarchischen Belegungskarten. Universität der Bundeswehr München. Retrieved from http://d-nb.info/1030485593/]

Einige Menschen wissen noch nicht mal wofür sie einen Tempomat brauchen, da hat die Automobilindustrie schon die adaptive Version davon entwickelt. Vertrieben werden diese unter vielen Marketingnamen, wie beispielsweise Adaptive Cruise Control (kurz: ACC, von Bosch) oder Distronic Plus (von Daimler). Letztere konnte ich mir im Rahmen einer Promotionveranstaltung mal etwas genauer ansehen.

Das ACC oder DistronicPlus hat die Aufgabe einem vorausfahrenden Fahrzeug mit konstantem Sicherheitsabstand zu folgen und, sollte es von der eigenen Spur verschwinden, auf die gewünschte Tempomatgeschwindigkeit zu beschleunigen, bis wieder ein Hindernis in der eigenen Spur auftaucht.

Die neue A-Klasse von Mercedes-Benz hat serienmäßig den Collision Prevention Assist (Warnung bei drohendem Auffahrunfall und Vorbereitung des Fahrzeugs auf die kommende Vollbremsung) an Board. Dieser wird bei Daimler mit einem Radar Sensor gefüttert. Als optionales Paket kann man sich die Distronic Plus, also die automatische Abstandsregulierung dazu ordern.

Doch wie funktioniert das und wo liegen die Probleme?